Máquinas que deciden matarnos: muerte lavanda

Cuarta parte de la serie "Israel: Inteligencia Artificial vs. la Humanidad"

“Máquinas que deciden matarnos: aroma lavanda” es la cuarta parte de la serie “Israel: Inteligencia Artificial vs. la Humanidad”.

Las otras son:

1. Máquinas que nos vigilan: el apartheid biométrico (haz clic aquí)

2. “Máquinas que nos matan: killer robots” (haz clic aquí)

3. Máquinas que deciden matarnos: el evangelio (haz clic aquí)

5. Expo-Gaza: feria y laboratorio con gente real (haz clic aquí)

Esta actualización es enviada por adelantado a nuestros suscriptores de pago a las 20 horas del miércoles, como agradecimiento de su mecenazgo. A las 8 horas del jueves, el acceso libre será completo para toda la audiencia.

MundoAbierto.info es una publicación con el respaldo de su comunidad. Para recibir nuevos posts y apoyar nuestro trabajo, considera convertirte en un suscriptor gratis o de pago.

Israel ha asegurado que la IA le permite salvar vidas civiles. Pero el número sin precedentes de víctimas indica lo contrario. Y de hecho, el 9 de octubre, en una de sus primeras declaraciones al inicio de la guerra, el portavoz militar Daniel Hagari adelantó que “el énfasis estará en (causar) daño, no en la precisión”.

En la primera entrega de la investigación de los medios israelíes Sikha Mekomit y +972, que referimos en la tercera parte de esta serie de Mundo Abierto, se indicó que la definición de objetivos humanos también era una tarea del sistema HaBsora, “el evangelio”.

Sin embargo, tres meses después, a través de nuevas conversaciones sostenidas con seis oficiales activos de la inteligencia israelí, pudieron corregir al encontrar que existe una división de tareas, y que esta última corresponde a otra plataforma, conocida como “Lavanda”.

Formalmente, se dedica a identificar a todos los miembros de las alas militares de las organizaciones Hamás y Jihad Islámica, incluyendo a sus operadores de menor nivel, para designarlos como blancos de bombardeo, estableciendo también dónde viven y otros puntos clave para localizarlos.

Se calcula que, al principio de la ofensiva, su lista era de 37 mil personas.

¿Cuáles son los criterios para concluir que alguien es parte del ala militar?

Según la investigación, Israel los ha expandido hasta hacerlos muy laxos. Ya que Hamás controlaba el gobierno de Gaza, muchos civiles tenían relación directa con el grupo, como policías, médicos, empleados de telecomunicaciones, trabajadores de la construcción, maestros y en general, gente que laboraba en ramas de la administración pública.

Por ejemplo, hay dos colectivos que han tenido muchas víctimas atacadas directamente por Israel: los trabajadores de UNRWA (la agencia de refugiados de la ONU: Tel Aviv ha matado a 193, acusó a 12 de sus 30 mil empleados de ser miembros de Hamás, sin pruebas, y exige el cierre del organismo) y los periodistas (al menos 107 asesinados).

Asesinatos algorítmicos

Los algoritmos de Lavanda analizan enormes volúmenes de información para identificar patrones. Su eficacia depende tanto de la calidad como de la cantidad de datos que procesa, y utiliza los patrones para hacer predicciones basadas en la probabilidad: si un individuo comparte suficientes características con otros identificados como combatientes enemigos, el sistema lo etiqueta como blanco, aunque no exista plena certeza.

Según el reporte de Sikha Mekomit y de +972, “el ejército ha expandido significativamente el bombardeo de objetivos de naturaleza no militar”. Cuenta con archivos sobre la gran mayoría de objetivos potenciales en Gaza, incluyendo hogares, que estipulan el número de civiles que probablemente morirán en un objetivo determinado. “Este número es calculado y conocido previamente por las unidades de inteligencia militar, que también saben, poco tiempo antes de un ataque, exactamente y con certeza cuántos civiles morirán” (aunque, como veremos más adelante, suelen subestimar esta cifra y matan a mucha más gente).

Otras veces, “bombardeamos con base en una señal de celular que, en una zona amplia, indica dónde está el blanco, matando a civiles. Con frecuencia, esto se hace para ahorrar tiempo, en lugar de hacer algo más de trabajo para conseguir una indicación más precisa”.

Las fuentes de la investigación indicaron que ha aumentado exponencialmente la permisividad para matar a civiles como “daños colaterales” en casos, por ejemplo, como el intento de asesinar a un solo alto mando militar de Hamás: “Los números se incrementaron de docenas de muertes de civiles en operaciones previas, a cientos de muertes de civiles”.

“Nada pasa por accidente”, declaró uno de los informantes que conocen la inteligencia israelí. “Cuando matan a una niña de tres años en un hogar de Gaza, es porque alguien en el ejército decidió que no era un gran problema que la mataran, que era un precio correcto a pagar para acabar con el objetivo. No somos Hamás. Estos no son cohetes que van a caer en cualquier lugar. Todo es intencional. Sabemos exactamente cuánto daño colateral causamos en cada casa”.

Matar en el hogar, “primera opción”

Después de identificar el objetivo, Lavanda lo vincula a un sitio y momento, que suele ser su hogar por la noche -con familia incluida- porque es la manera más fácil de atacarlo. “No estábamos interesados en matar a agentes (de Hamás) solo cuando estaban en un edificio militar o participando en una actividad militar”, reveló una de las fuentes. “Por el contrario, los bombardeamos en sus casas sin dudarlo, como primera opción. Es mucho más fácil bombardear la casa de una familia. El sistema está diseñado para buscarlos en estas situaciones”.

En este punto, Lavender interactúa con otro sistema de IA, apodado “¿Dónde está papá?”, que sirve para rastrear a las personas objetivo y llevar a cabo el bombardeo cuando está en su casa.

Lavender recomienda un tipo de arma específico para emplear en su contra, con un cálculo costo-beneficio: las bombas más caras, las de precisión, son empleadas sobre comandantes de batallón o de brigada. Como los miembros de menor rango (los llaman “objetivos basura”) no ameritan un gran gasto, les lanzan las llamadas “bombas bobas”, que son más baratas y tienen mayor riesgo de provocar daños colaterales.

Esto va en contradicción con las reglas del ejército de Israel que establecen cuántos civiles es permisible matar en la eliminación de un objetivo: de 15 a 20 si se trata de alguien de bajo nivel y hasta 300 si es una figura de relevancia.

En principio, el papel del analista humano en la decisión asesina de la Inteligencia Artificial es descartar mujeres. Pero ellas y los niños constituyen tres cuartas partes de las personas que matan en Gaza.

Errores de la IA

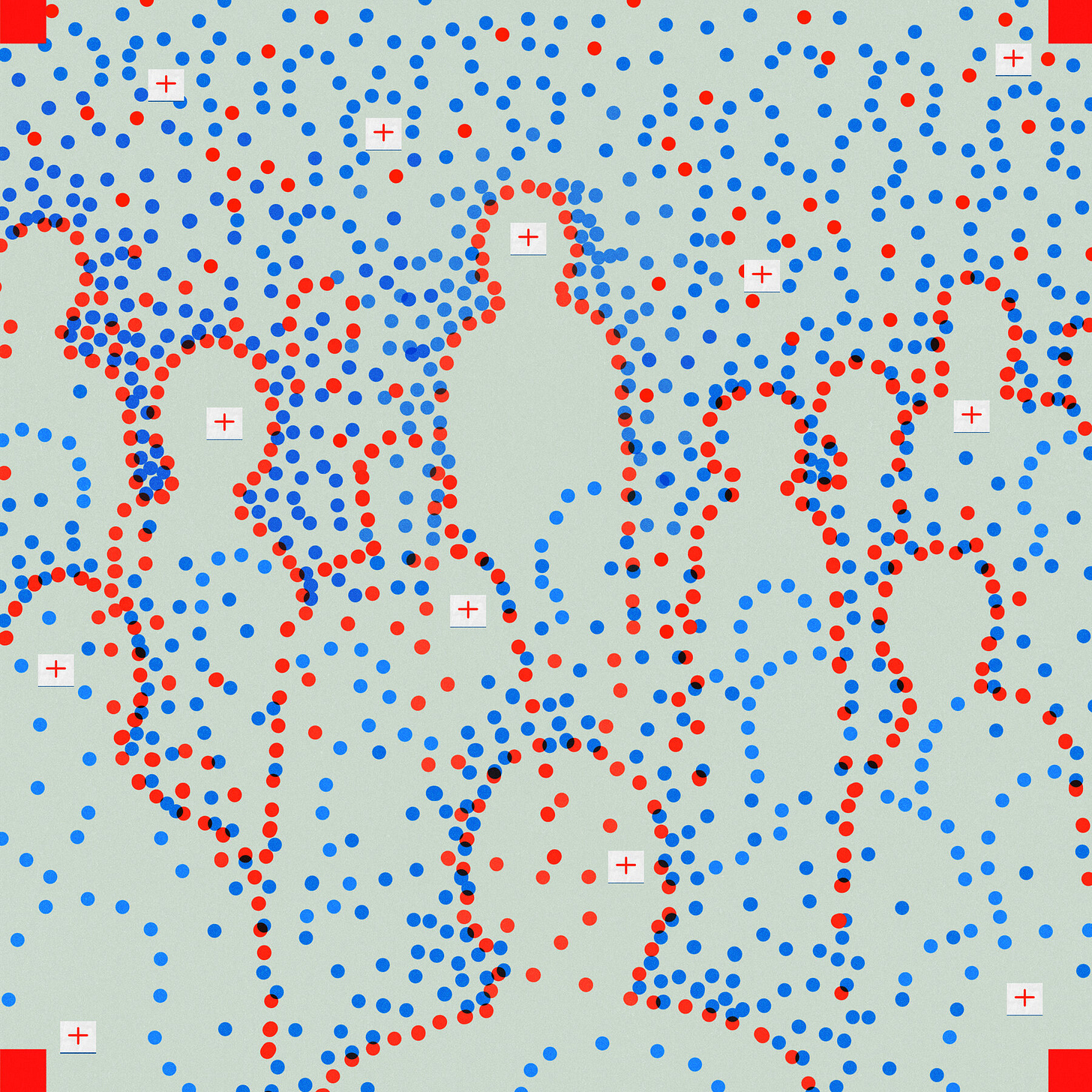

Un reportaje del New York Times publicado en octubre reveló el uso de un sistema que, con base en las señales de celular, le daba al ejército un estimado del número de palestinos que habían escapado del norte de Gaza y se dirigían al sur. Opera con colores: el rojo marca las áreas donde hay mucha gente, y el verde y el amarillo marcan las que han sido relativamente despejadas de residentes.

Este mismo código se usa para indicar la estimación de cuántas personas hay en una casa o edificio que va a ser bombardeado. Esto se hace evaluando el tamaño del edificio y revisando su lista de habitantes, y luego se reduce esa cifra según la proporción de residentes que supuestamente evacuaron el vecindario. Por ejemplo, si creían que la mitad de las personas de un barrio se había ido, el programa contaría una casa que normalmente tenía 10 residentes como conteniendo a cinco personas.

Las fuentes dijeron a Sikha Mekomit y +972 que estos datos no son verificados por seres humanos y no suelen ser correctos, de manera que a veces “bombardeamos una casa sin saber que dentro hay varias familias escondidas juntas”. Pero de todos modos se adoptó este modelo impreciso porque es más rápido.

Y así como falla Lavanda, lo hace el sistema ¿Dónde está papá? Además de que con frecuencia transcurre un lapso considerable entre el momento en que se da la alerta de que el objetivo ha llegado a su hogar y el ataque. “Me pasó muchas veces que atacamos una casa, pero la persona ni siquiera estaba ahí", dijo una fuente. "El resultado es que mataste a una familia sin ningún motivo".

En guerras anteriores, la inteligencia israelí llevaba a cabo valoraciones de daños para verificar si el objetivo había muerto. Por ejemplo, intervenían llamadas de los familiares para saber si lamentaban la pérdida de alguien.

Ahora solo lo hacen con los de mayor importancia. “No sabes exactamente a cuántos mataste ni a quién mataste”, dijo una de las fuentes. “Sólo cuando se trata de altos funcionarios de Hamás se sigue ese procedimiento (de verificación). En el resto de casos, no te importa. Recibes un informe de la fuerza aérea sobre si el edificio fue volado y eso es todo. No tienes idea de cuántos daños colaterales hubo, inmediatamente pasas al siguiente objetivo. El énfasis es crear tantos objetivos como sea posible, lo más rápido posible”.

El proceso fue abandonado en esta ofensiva porque, a pesar de que la finalidad de confiarle estas tareas a la Inteligencia Artificial es hacer las cosas de manera más veloz y precisa, los militares sienten que les hace perder tiempo y han perdido interés por la precisión.

Expo-Gaza

Pese a las fallas, en todo caso, al tiempo en que Israel lleva a cabo su exterminio también está probando y demostrando sus nuevas armas, para vendérselas al mundo.

Ese es el tema de la próxima entrega de esta serie de Mundo Abierto.

¡Gracias por acompañarme hasta aquí!

La mayor parte del contenido de Mundo Abierto es de acceso libre para todo el mundo porque el objetivo principal es compartir la información y el análisis.

Esto solo es posible con el apoyo de los suscriptores de pago que sostienen el proyecto por una pequeña cantidad mensual.

Agradezco a quienes se han comprometido con una suscripción de pago, en particular al Patrocinio Destacado de:

💛💜 Ximena Santaolalla Abdó 💛💜

💛💜 José Luis Aguilar Carbajal 💛💜

💛💜 Martha Barbiaux 💛💜

💛💜 Sergio Guarneros Aguilera 💛💜

💛💜 Beatriz Rivas Ochoa 💛💜

💛💜 mslreflexiones 💛💜

La censura -el shadow banning o prohibición oculta- tiró el tráfico de mis cuentas de redes sociales, haciéndolo caer en 80 y hasta 90%, como expliqué aquí (además, lo reporteé más a fondo aquí).

Para combatir esta censura, te convoco a actuar.

Comparte. Recomienda. Comenta. Platica sobre lo que te interesó.

Sígueme en Instagram, X, Facebook, Tik Tok, YouTube, Threads, vía @temoris.

Suscríbete a Mundo Abierto gratis.

Y si está en tus posibilidades actuales, toma o regala una suscripción de pago.

Otras vías de pago o donaciones:

Transferencia (por favor, avísanos a ojosdeperromx@gmail.com):

Témoris Grecko Berumen Alegre

Banco BBVA (México)

Cuenta 1275656486

CLABE: 012 180 01275656486 4

Código SWIFT BCMRMXMMPYM

O vía Stripe (acepta tarjetas bancarias, Google Pay, Apple Pay y Oxxo)

(Para Stripe, puedes seguir este QR)

O vía Paypal (haz clic aquí paypal.me/temorisg )

Solo una sociedad que apoya a su periodismo goza de un periodismo que la sirve a ella ✊

Los otros periodismos sirven a quienes les pagan: poderes económicos, políticos, religiosos y otros…