Máquinas que deciden matarnos: el evangelio criminal

Tercera parte de la serie "Israel: Inteligencia Artificial vs. la Humanidad"

“Máquinas que deciden matarnos: el evangelio criminal” es la tercera parte de la serie “Israel: Inteligencia Artificial vs. la Humanidad”.

Las otras son:

1. Máquinas que nos vigilan: el apartheid biométrico (haz clic aquí)

2. “Máquinas que nos matan: killer robots” (haz clic aquí)

4. Máquinas que deciden matarnos: muerte lavanda (haz clic aquí)

5. Expo-Gaza: feria y laboratorio con gente real (haz clic aquí)

Esta actualización es enviada por adelantado a nuestros suscriptores de pago a las 21 horas del lunes, como agradecimiento por su mecenazgo. A las 21 horas del martes, el acceso será completo para toda la audiencia.

MundoAbierto.info es una publicación con el respaldo de su comunidad. Para recibir nuevos posts y apoyar nuestro trabajo, considera convertirte en un suscriptor gratis o de pago.

En la guerra de 2014, los periodistas que estábamos presentes en Gaza observamos un cambio súbito en el tipo de objetivos que estaba bombardeando el ejército israelí, cuando la ofensiva estaba entrando apenas en la tercera de sus siete semanas de duración. Ya no parecían atacar blancos con posible interés militar. De pronto, una fábrica de harina, un estacionamiento o una tienda de teléfonos celulares.

Después se conocería cuál era la razón: ya habían agotado su lista de elementos a destruir. Habituados a escaladas bélicas relativamente breves, quisieron asegurarse de cumplir en 15 días las metas que sus analistas habían fijado. Pero esa algarada duró 51 jornadas, bastante más de lo normal (y muchísimo menos que la actual). Tel Aviv no quería ir a la mesa de negociaciones dando una impresión de debilidad al reducir su ritmo de fuego por falta de objetivos, de manera que lo sostuvo, golpeando lo que fuera, y obviamente, al costo humano que resultara.

Han logrado cambiar gracias a la Inteligencia Artificial. Uno de los usos que se preveían y temían era en la eficiencia de matar. Israel está probando en gente de verdad las tecnologías que pronto venderá al mundo, en este caso en una generación de blancos militares con velocidades sorprendentes.

El 30 de junio del año pasado, el general y ex jefe del Estado Mayor Aviv Kochavi le dio una entrevista al periódico Yediot Ahronot, que en ese momento pasó desapercibida, en la que se refirió a un grupo establecido solo tres años antes, la División Administrativa de Objetivos, compuesta de cientos de oficiales y soldados que emplean inteligencia artificial.

No mencionó el nombre de la nueva plataforma pero la describió como “una máquina que procesa vastas cantidades de datos más rápido y más efectivamente que cualquier ser humano, convirtiéndolas en objetivos accionables. En la Operación Guardián de las Murallas [una ofensiva contra Gaza de 11 días en mayo de 2021], una vez que activamos esta máquina, generó 100 objetivos nuevos cada día. Para ponerlo en perspectiva, en el pasado producíamos 50 objetivos en Gaza cada año”.

Es decir, en ese momento, en 365 días podían definir 3 mil 650 blancos en lugar de 50. Hace tres años. Ahora es probable que sean más.

Y existe un elemento extra que hace que esa pesadilla de ciencia ficción materializada en la realidad sea todavía más inquietante: estas tecnologías de Inteligencia Artificial todavía no son sistemas de armamento autónomos, o sea, robots que deciden si matan a una persona o no.

Pero en los hechos, ya funcionan como tales. Porque la intervención humana es prácticamente una formalidad, un trámite: los analistas que validan los objetivos que definen estas máquinas lo hacen en 20 segundos por cada uno, según testimonios, y llevan a cabo una sola verificación: que se trate de un sujeto masculino y no femenino. A pesar de que se estima que hay una tasa de error del 10%.

Las máquinas deciden.

Para complicar más las cosas: la idea de que la designación de una persona o un lugar como un blanco es producto de un proceso algorítmico validado enfría el acto de matar, lo despersonaliza. El soldado asume que ha recibido la orden generada por un sistema perfecto, ajeno a debilidades humanas, y que por lo tanto, él debe ejecutarla sin considerar las consecuencias, él no es nadie para juzgar. Todo es científico.

Esto también puede ser utilizado, eventualmente, para tratar de desvanecer responsabilidades: ¿a quién sentarían en el banquillo de un tribunal internacional por un crimen de guerra? ¿Al que apretó el gatillo, al técnico informático, a los generales… o a la máquina?

Fábrica de asesinatos en masa

El 2 de noviembre de 2023, el ejército israelí reconoció en un comunicado de prensa el uso de una plataforma de IA de generación de objetivos que se llama “HaBsora” (en hebreo, “El Evangelio”), la cual, “a través de la extracción automática y rápida de inteligencia actualizada produce blancos a un ritmo veloz. Genera una recomendación para el investigador, con el objetivo de que haya una correlación completa entre la recomendación de la máquina y la identificación realizada por una persona”.

Una investigación de los medios israelíes Sikha Mekomit y +972, publicada el 30 de noviembre, incluyó los testimonios de siete miembros actuales y retirados de la comunidad de inteligencia israelí, que revelaron cómo funciona HaBsora: crea objetivos empleando un método denominado “inferencia probabilística”, mediante el que los algoritmos analizan grandes cantidades de datos para identificar edificios y otras estructuras a bombardear.

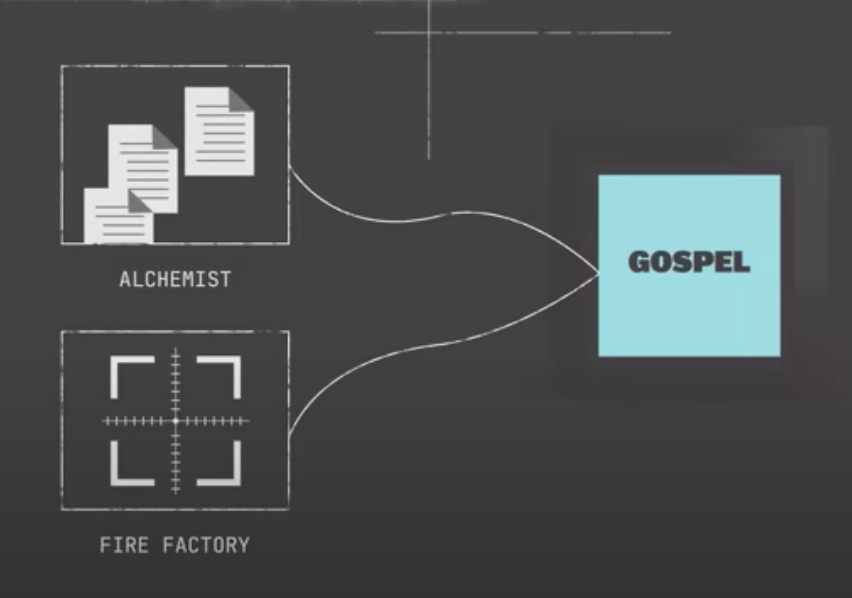

HaBsora se apoya en otras dos aplicaciones de IA: “Alquimista”, que reúne datos históricos y de vigilancia y facilita que esta información sea compartida por distintos departamentos.

La otra es “Fábrica de Fuego”, que utiliza los datos de los objetivos aprobados para calcular cargas de munición, priorizar miles de blancos para la aviación y los drones y plantear una calendarización de ataques.

HaBsora categoriza los blancos en cuatro grupos:

Objetivos tácticos: grupos de militantes armados, arsenales, lanzadores de cohetes y misiles antitanque, y cuarteles y puestos de observación.

Objetivos subterráneos: todo lo que pueda estar en los famosos túneles de Gaza y encima de ellos.

Hogares: Donde viven las familias de los supuestos militantes de Hamás y Jihad Islámica.

Objetivos de poder: torres y edificios de departamentos, oficinas, bancos, universidades y diferentes servicios. Son de carácter civil: la finalidad de destruirlos es afectar a la población para provocar que se vuelva contra sus gobernantes.

La investigación muestra que en los primeros cinco días de “Espadas de Hierra”, la operación en curso, las fuerzas israelíes atacaron 2 mil 687 objetivos, de los que la mitad, mil 329, eran “objetivos de poder”.

Estos sistemas de Inteligencia Artificial, según describió una de las fuentes a los investigadores, “esencialmente facilitan una fábrica de asesinatos en masa”.

Lavanda

Los objetivos de mayor interés para el ejército, por supuesto, son seres humanos. Pero de esos se encarga otro sistema de Inteligencia Artificial, que es el tema de la próxima entrega de esta serie de Mundo Abierto.

¡Gracias por acompañarme hasta aquí!

La mayor parte del contenido de Mundo Abierto es de acceso libre para todo el mundo porque el objetivo principal es compartir la información y el análisis.

Esto solo es posible con el apoyo de los suscriptores de pago que sostienen el proyecto por una pequeña cantidad mensual.

Agradezco a quienes se han comprometido con una suscripción de pago, en particular al Patrocinio Destacado de:

💛💜 Ximena Santaolalla Abdó 💛💜

💛💜 José Luis Aguilar Carbajal 💛💜

💛💜 Martha Barbiaux 💛💜

💛💜 Sergio Guarneros Aguilera 💛💜

💛💜 Beatriz Rivas Ochoa 💛💜

💛💜 mslreflexiones 💛💜

La censura -el shadow banning o prohibición oculta- tiró el tráfico de mis cuentas de redes sociales, haciéndolo caer en 80 y hasta 90%, como expliqué aquí (además, lo reporteé más a fondo aquí).

Para combatir esta censura, te convoco a actuar.

Comparte. Recomienda. Comenta. Platica sobre lo que te interesó.

Sígueme en Instagram, X, Facebook, Tik Tok, YouTube, Threads, vía @temoris.

Suscríbete a Mundo Abierto gratis.

Y si está en tus posibilidades actuales, toma o regala una suscripción de pago.

Otras vías de pago o donaciones:

Transferencia (por favor, avísanos a ojosdeperromx@gmail.com):

Témoris Grecko Berumen Alegre

Banco BBVA (México)

Cuenta 1275656486

CLABE: 012 180 01275656486 4

Código SWIFT BCMRMXMMPYM

O vía Stripe (acepta tarjetas bancarias, Google Pay, Apple Pay y Oxxo)

(Para Stripe, puedes seguir este QR)

O vía Paypal (haz clic aquí paypal.me/temorisg )

Solo una sociedad que apoya a su periodismo goza de un periodismo que la sirve a ella ✊

Los otros periodismos sirven a quienes les pagan: poderes económicos, políticos, religiosos y otros…